Hat Ihnen der Artikel weitergeholfen? Dann teilen Sie ihn gerne mit Ihren Kolleg:innen.

Einleitung

In vielen Organisationen ist Geschäftsprozessmanagement (GPM) still und leise zu einem Paradox geworden. Es ist weit verbreitet, tief in Transformationsinitiativen verankert und soll zunehmend Compliance, Automatisierung und Performance unterstützen – wird jedoch noch immer häufig eher als Dokumentationsaufgabe denn als strategische Fähigkeit verstanden.

Mit zunehmendem regulatorischem Druck, beschleunigter KI-Adoption und wachsender operativer Komplexität lässt sich diese Lücke immer schwerer ignorieren. GPM soll heute nicht mehr nur beschreiben, wie Arbeit idealerweise ablaufen sollte. Es wird erwartet, Organisationen zusammenzuhalten, während Veränderung zum Dauerzustand wird.

Diese Entwicklung spiegelt sich auch in unserer GPM-Studie 2025 wider, die auf Erkenntnissen von fast 300 Organisationen aus unterschiedlichsten Branchen basiert. Die Ergebnisse zeigen: Obwohl GPM weit verbreitet ist, bleibt der Reifegrad vielerorts uneinheitlich und weitgehend stagnierend. Die meisten Organisationen bewegen sich weiterhin auf einem frühen bis mittleren Reifegradniveau – mit kaum Veränderungen zwischen 2023 und 2025. Nur rund 15 % haben ein fortgeschrittenes Reifestadium erreicht.

Anders gesagt: Die Erwartungen an GPM steigen schneller als sein Reifegrad.

Für 2026 stellt sich daher nicht mehr die Frage, ob Organisationen GPM benötigen, sondern was sie konkret von GPM erwarten. Die folgenden Trends zeigen, wie sich GPM weiterentwickelt, um diesen Erwartungen gerecht zu werden – von tatsächlicher Nutzung und besserer Anwendbarkeit über die Verankerung von Nachvollziehbarkeit und Governance bis hin zur Rolle als Fundament für Automatisierung und Transformation.

Trend 1: Prozesserlebnis treibt Akzeptanz voran

Mit steigenden Erwartungen an GPM tritt eine zentrale Herausforderung sofort zutage: Prozesse schaffen nur dann Mehrwert, wenn sie tatsächlich genutzt werden. Unabhängig davon, wie ausgereift Modelle oder Frameworks im Hintergrund sind – ohne breite und konsistente Akzeptanz kann GPM seine Rolle als operative Infrastruktur nicht erfüllen.

Der entscheidende Unterschied liegt 2026 daher nicht mehr darin, ob Organisationen über Prozessmodelle verfügen, sondern ob Mitarbeitende Prozesswissen im Arbeitsalltag einfach finden und anwenden können.

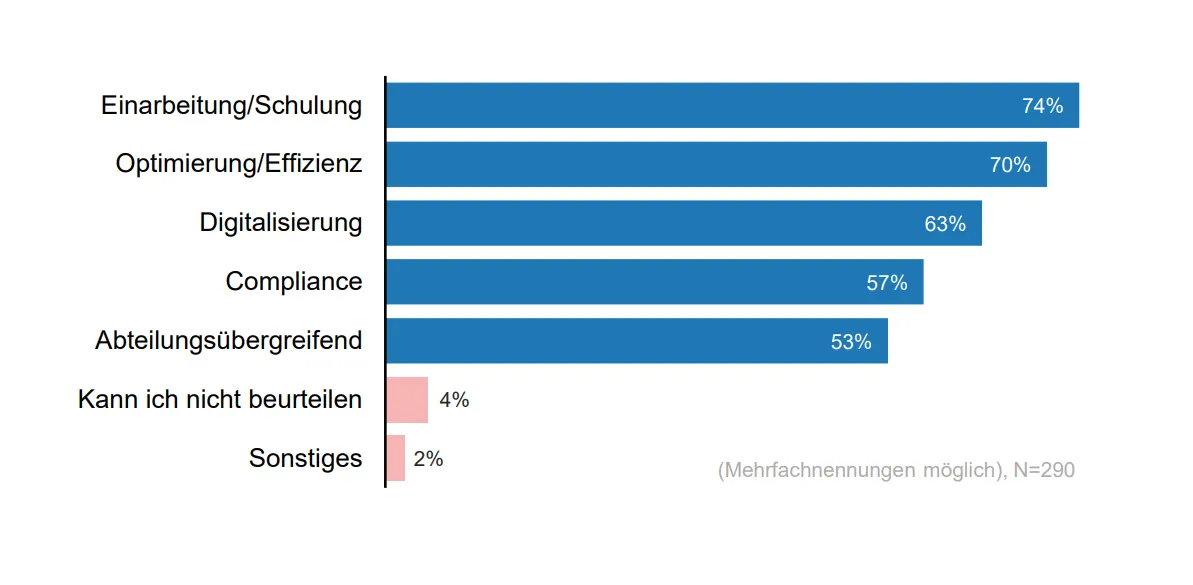

Genau hier zeigt GPM bereits heute seinen größten Nutzen. Die GPM-Studie belegt, dass Prozessdokumentation ihren stärksten Beitrag im Einarbeitung und Schulung (74 %), in der Prozessoptimierung (70 %), der Digitalisierung (63 %), der Compliance (57 %) sowie in der abteilungsübergreifenden Zusammenarbeit (53 %) leistet. Allen diesen Anwendungsfällen ist nicht methodische Komplexität gemeinsam, sondern Benutzbarkeit: Prozesse müssen leicht auffindbar, verständlich und für konkrete Rollen und Aufgaben relevant sein.

Für ADONIS Anwender:innen deckt sich das mit der Positionierung des Prozessportals: Prozesswissen wird durch Suche, Navigation über die Prozesslandkarte sowie rollen- oder bereichsbezogenen Zugriff zu einem selbstverständlichen Bestandteil des Arbeitsalltags.

Was sich 2026 verändert

-

Veröffentlichung wird zur Produktdisziplin – mit klarer Verantwortung, durchdachter Struktur und verbindlichen Qualitätsstandards.

-

Das Prozessportal wird zur zentralen Anlaufstelle für die „freigegebene Wahrheit“ – nicht mehr zu einer statischen Ablage.

-

Akzeptanz wird mit derselben Konsequenz gesteuert wie Modellqualität.

Zur Veranschaulichung: Stellen Sie sich ein neues Mitglied im HR-Team vor, das den korrekten Onboarding-Prozess für einen regulierten Standort sucht. Statt sich durch geteilte Ordner oder Intranet-Seiten zu arbeiten, greift die Person auf einen einzigen, freigegebenen Prozess im Portal zu – mit rollenspezifischen Einstiegspunkten und eingebetteten Arbeitsanweisungen, die exakt dem genehmigten Ablauf entsprechen. Fragen lassen sich konsistent klären, auf Basis eines gemeinsamen Verständnisses darüber, wie der Prozess tatsächlich vorgesehen ist.

Sobald diese Akzeptanz etabliert ist, rückt der nächste Hebel in den Fokus: Geschwindigkeit – und genau hier kommt KI ins Spiel.

Trend 2: KI als GPM-Co-Pilot

KI im Geschäftsprozessmanagement entwickelt sich von ersten Experimenten hin zu reproduzierbarer Produktivität.

Die GPM-Studie zeigt, dass KI bereits eine relevante Rolle spielt: 43 % der Organisationen nutzen Large Language Models aktiv, weitere 23 % evaluieren KI-fähige Werkzeuge. Gleichzeitig bleibt der Einsatz bislang meist lokal und unterstützend – statt durchgängig im gesamten GPM-Lebenszyklus verankert zu sein.

Das spiegelt den aktuellen Stand vieler Organisationen wider: KI wird dort eingesetzt, wo sie als risikoarm wahrgenommen wird. Eine breitere Integration scheitert jedoch häufig an unklaren Verantwortlichkeiten, inkonsistenten Daten und fehlenden Governance-Strukturen.

Warum der Wandel jetzt beginnt

2026 setzt hier ein Umdenken ein – nicht, weil KI plötzlich deutlich leistungsfähiger wird, sondern weil Organisationen zunehmend unter Druck stehen, über isolierte Pilotprojekte hinauszugehen.

Analystenstudien bestätigen diesen Wendepunkt. Gartner prognostiziert, dass viele generative KI-Initiativen nach der Proof-of-Concept-Phase eingestellt werden – aufgrund von Kosten, Komplexität, schwachen Datenbasen und unklarer Governance. Gleichzeitig betont Gartner die wachsende Bedeutung von KI-bereiter Daten und agentischer KI. Beides macht deutlich: Skalierbare KI erfordert deutlich stärkere operative Grundlagen als reine Experimente.

Parallel dazu zeigen Studien von Deloitte und McKinsey & Company, dass Organisationen KI-Anwendungsfälle zunehmend dort priorisieren, wo messbare Produktivitätsgewinne im Kerngeschäft erzielt werden können – insbesondere in Dokumentation, Analyse, Koordination und Entscheidungsunterstützung. Genau diese Bereiche sind eng mit GPM verknüpft.

Für das Geschäftsprozessmanagement bedeutet das einen Rollenwechsel: von KI als unterstützendes Tool hin zu KI als Co-Pilot, der in gesteuerte Prozesse eingebettet ist, um Verständnis und Veränderung zu beschleunigen – ohne Verantwortlichkeiten zu ersetzen. Wichtig dabei: Es geht nicht um vollständig autonome Prozessausführung. Analyst:innen zeigen vielmehr, dass KI-Initiativen ohne Governance, verlässliche Daten und operative Verantwortung häufig stagnieren oder scheitern. Genau hier bestätigt sich GPM als strukturierende Ebene, die KI skalierbar, prüfbar und vertrauenswürdig macht.

Wobei KI GPM konkret unterstützt

2026 unterstützt KI zunehmend jene alltäglichen GPM-Aufgaben, bei denen heute am meisten Zeit verloren geht:

-

Erstellen und Aktualisieren von Prozessdokumentationen

-

Zusammenfassen komplexer Prozesskontexte

-

Klassifizieren von Verantwortlichkeiten, Kontrollen und Abhängigkeiten

-

Schnelleres Verständnis für Nicht-Experten

Statt GPM-Expertise zu ersetzen, reduziert KI Reibungsverluste und ermöglicht es mehr Menschen, effektiv mit Prozesswissen zu arbeiten.

In ADONIS zeigt sich das darin, wie der KI-Assistent unterschiedliche GPM-Aufgaben unterstützt – von kontextbezogener Hilfe bei der Prozesserkundung bis hin zu tiefergehender Unterstützung in Design und Dokumentation.

Governance und Datenreife als begrenzende Faktoren

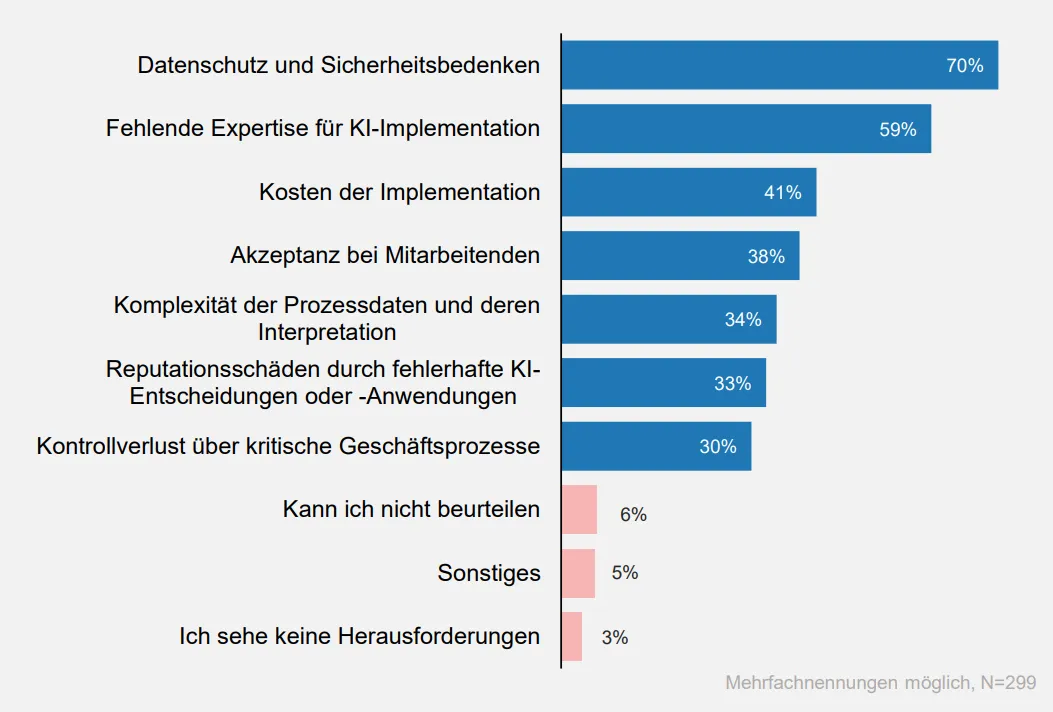

Die größte Hürde bei der Skalierung von KI im Geschäftsprozessmanagement ist nicht mehr die technische Leistungsfähigkeit, sondern die Governance-Reife. Die GPM-Studie zeigt anhaltende Barrieren wie Datenschutz- und Sicherheitsbedenken (70 %), fehlende Expertise (59 %), Kosten (41 %) und begrenzte Akzeptanz (38 %). Hinzu kommen wahrgenommene Risiken, etwa Reputationsschäden durch fehlerhafte oder verzerrte Entscheidungen (33 %) sowie der Kontrollverlust über kritische Geschäftsprozesse (30 %).

Für das Geschäftsprozessmanagement ist die Konsequenz eindeutig: KI-Ergebnisse müssen Vorschläge bleiben, bis sie über definierte Rollen und Workflows geprüft, freigegeben und veröffentlicht werden. So bleibt GPM eine autoritative Quelle der Wahrheit, während KI Analyse und Veränderung beschleunigen kann.

Zuverlässige Daten sind dabei eine Grundvoraussetzung. Analyst:innen verknüpfen den Erfolg von KI durchgängig mit AI-ready Data – für GPM bedeutet das ganz konkret: ein gepflegtes, aktuelles und freigegebenes Prozessportfolio. Fehlt diese Grundlage, bleiben Organisationen in isolierten KI-Anwendungsfällen stecken und kommen kaum zu einer breiteren Nutzung.

Ein kurzer Blick auf MCP

Das Model Context Protocol (MCP) übernimmt eine unterstützende Rolle, indem es standardisiert, wie LLM-basierte Anwendungen mit Werkzeugen und Datenquellen verbunden werden. Das reduziert individuelle Integrationen und ermöglicht skalierbarere KI-Muster – allerdings nur in Kombination mit klarer Prozessverantwortung, definierten Freigabestandards und klaren Governance-Grenzen, wie sie durch GPM bereitgestellt werden.

Empfehlungen für die Umsetzung

-

KI-Interaktionen auf genehmigte, freigegebene Prozessinhalte beschränken

-

Wiederkehrende Fragen- und Nutzungsmuster je Rolle standardisieren

-

Klare Regeln für den Umgang mit KI-Ergebnissen definieren: Vorschlag, Prüfung, Freigabe und nachvollziehbare Änderung

-

KI-fähiges Prozesswissen etablieren – durch klare Ownerships, Aktualitätsroutinen und verbindliche Freigabestandards

KI erhöht die Geschwindigkeit. Governance und Datenqualität entscheiden, ob daraus nachhaltiger Nutzen entsteht.

Trend 3: Process Mining wird zum Evidenzstandard

Mit zunehmender Reife des Geschäftsprozessmanagements reicht eine rein intuitive Neugestaltung nicht mehr aus. 2026 starten Verbesserungsinitiativen immer häufiger auf Basis von Ausführungsdaten, nicht von Annahmen.

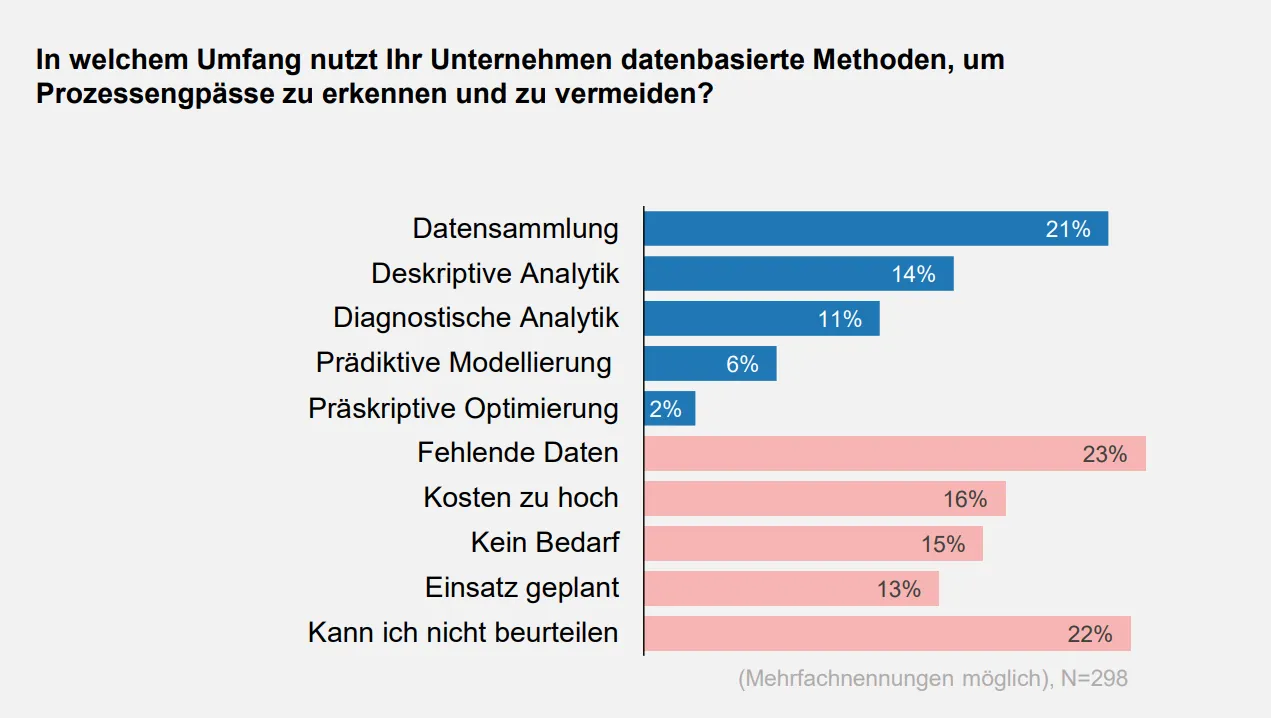

Process Mining ist in vielen Organisationen noch kein Standard, entwickelt sich jedoch klar zum Evidenzfundament für besonders wirkungsrelevante Prozesse – dort, wo Abweichungen hohe Kosten verursachen und Veränderungsentscheidungen risikobehaftet sind. Die GPM-Studie zeigt, dass viele Organisationen weiterhin eine geringe Analyse-Reife aufweisen: 21 % erfassen lediglich Rohdaten, 14 % nutzen deskriptive Analysen, und nur 11 % setzen auf diagnostische Ansätze wie Process Mining. Gleichzeitig wächst die Absicht – 13 % planen die Einführung von Process Mining.

In zunehmend automatisierten und vernetzten Umgebungen ist es schlicht zu teuer, auf unvollständige oder irreführende Erkenntnisse zu reagieren.

Externe Studien bestätigen diese Entwicklung. Deloitte zeigt, dass Organisationen den Einsatz von Process Mining ausweiten und zunehmend mit KI kombinieren, um Erkenntnisgewinn und Ursachenanalyse zu skalieren – getrieben durch stärker digitalisierte Ausführungsdaten, höhere Kosten von Abweichungen und den wachsenden Druck, Verbesserungs- und Automatisierungsentscheidungen mit belastbaren Daten zu untermauern.

Beispiel:

Ein Purchase-to-Pay-Prozess ist scheinbar gut dokumentiert, dennoch fallen regelmäßig Verzugsgebühren an. Process Mining zeigt, dass die Ursache nicht in Freigabeverzögerungen liegt, sondern in wiederholter Nacharbeit aufgrund fehlender Stammdaten und uneinheitlicher Rechnungsformate. Die Organisation korrigiert den Standard an der Fehlerquelle, aktualisiert die Arbeitsanweisungen dort, wo das Problem entsteht, und stabilisiert die Ausführung – bevor gezielte Automatisierung für klar definierte, wiederholbare Schritte eingeführt wird.

Diese Reihenfolge ist entscheidend. Process Mining automatisiert keine Prozesse, sondern liefert die Evidenz, um fundiert zu entscheiden, wo Automatisierung sinnvoll und sicher ist.

Für ADONIS Anwender:innen bildet genau diese Logik die Grundlage von Process Mining Essentials: Prozesserkennung, Konformitätsprüfung und Performance-Analyse, eingebettet in den GPM-Kontext und gesteuert über geregelte Verbesserungszyklen.

Empfehlungen für die Umsetzung

-

Vor der Analyse eine klare End-to-End-Basis und das gewünschte Ausführungsmodell definieren

-

Event-Log-Anforderungen mit GPM-Objekten abstimmen, sodass Erkenntnisse direkt auf Prozesswissen zurückgeführt werden können

-

Mining-Ergebnisse in einen gesteuerten Verbesserungs-Backlog überführen – mit klaren Verantwortlichkeiten und Freigabeentscheidungen

Evidenz zeigt Abweichungen auf. Governance entscheidet, welche davon zum neuen Standard werden.

Trend 4: Compliance wird im GPM verankert

Im Jahr 2026 verlagert sich Compliance zunehmend von einer reaktiven Aufgabe hin zu einer integrierten Eigenschaft der Art und Weise, wie Prozesse gestaltet, freigegeben und verändert werden.

Diese Entwicklung wird durch die GPM-Studie bestätigt, in der Compliance weiterhin ein zentraler Werttreiber der Prozessdokumentation ist (57 %). Was sich 2026 jedoch verändert, ist die operative Umsetzung von Compliance. Anstatt auf nachgelagerte Maßnahmen nach Audits zu setzen, reduzieren Organisationen Reibungsverluste, indem sie Anforderungen, Kontrollen und Verantwortlichkeiten direkt im GPM verankern – und diese über geregelte Freigabeprozesse konsequent durchsetzen.

Diese Entwicklung folgt etablierten Denkmodellen aus dem Compliance- und Kontrollumfeld. Standards wie ISO 37301 betonen ein systematisches, nachvollziehbares Compliance-Management, während Frameworks wie COSO hervorheben, wie wichtig es ist, Richtlinien und Kontrollen in operative Abläufe zu übersetzen, die den Arbeitsalltag steuern. GPM liefert genau diese operative Ebene, um diese Prinzipien in die Praxis zu überführen.

In der Konsequenz wachsen GPM und GRC operativ zusammen:

-

Prozesse definieren, wie Arbeit abläuft und wer verantwortlich ist

-

Kontrollen und Richtlinien sind im Prozesskontext nachvollziehbar verankert

-

Nachweise über Ausführung und Veränderungen sind jederzeit verfügbar – unterstützt durch Freigaben, Workflows und Audit-Trails

Das Ergebnis ist nicht mehr Dokumentation, sondern weniger manueller Compliance-Aufwand: klarere Verantwortlichkeiten, weniger unkontrollierte lokale Varianten und mehr Transparenz darüber, wer was wann und warum freigegeben hat.

Empfehlungen für die Umsetzung:

-

Compliance-Anforderungen expliziten Prozessschritten und Verantwortlichkeiten zuordnen

-

Auditierbare Freigabeworkflows für Genehmigungen und Änderungen nutzen

-

Routinen zur Änderungsfolgenabschätzung etablieren, um Richtlinien und Kontrollen bei Prozessanpassungen konsistent zu halten

Ist Compliance im GPM verankert, wird Governance kontinuierlich – nicht episodisch.

Trend 5: Standardisierung ermöglicht Skalierung

Im Jahr 2026 geht es bei der Skalierung des Geschäftsprozessmanagements nicht mehr darum, mehr Modelle zu erstellen, sondern Wiederverwendung zu erhöhen.

Solange Prozesse kopiert, lokal angepasst und separat gepflegt werden, bleibt jede Änderung ein Einzelfall – Verbesserungen verlangsamen sich, Abweichungen nehmen zu und nachgelagerte Initiativen verlieren an Wirkung. Standardisierung schafft hier Abhilfe, indem sie gemeinsame, gesteuerte Baselines etabliert, die einmal verbessert und anschließend konsistent über Bereiche, Regionen und Systeme hinweg genutzt werden können.

Standardisierung bedeutet dabei nicht den Verlust von Flexibilität. Sie macht Abweichungen sichtbar und steuerbar. Klare Unterscheidungen zwischen globalen Standards, begründeten Varianten und lokalen Anpassungen ermöglichen Skalierung, ohne die Kontrolle zu verlieren.

Die Prozessarchitektur spielt dabei eine zentrale Rolle. Referenzstrukturen wie das APQC Process Classification Framework schaffen eine gemeinsame Sprache zur Strukturierung der Prozesslandschaft, reduzieren Redundanzen und ermöglichen belastbare Vergleiche.

Empfehlungen für die Umsetzung:

-

Festlegen, welche Prozesse globale Standards sind, wo Varianten erlaubt sind und unter welchen Bedingungen

-

Governance-Regeln für Varianten einführen, inklusive Freigabe, Dokumentation und Pflege

-

Eine einheitliche Prozesstaxonomie nutzen, um nahezu identische Prozesse zu eliminieren und Wiederverwendung zu fördern

Standardisierung ermöglicht Skalierung. Governance macht sie beherrschbar. Intelligenz verwandelt sie in Leistung.

Trend 6: Von Prozesseinblicken zu entscheidungsreifer Intelligenz

Prozessintelligenz ist 2026 dann relevant, wenn sie Entscheidungen unterstützt, die einer Prüfung standhalten – nicht nur Dashboards erzeugt.

Viele Organisationen erfassen bereits Prozesskennzahlen. Entscheidungsreif werden Erkenntnisse jedoch erst, wenn sie mit Verantwortung und konkreten Maßnahmen verknüpft sind. Dafür ist der Schritt von reinem Reporting hin zu einem geschlossenen Kreislauf notwendig, in dem Erkenntnisse Veränderungen auslösen und diese wiederum anhand von Ergebnissen bewertet werden.

Die Entwicklung verläuft pragmatisch:

-

Zunächst deskriptive und diagnostische Transparenz stärken

-

Erkenntnisse klaren Verantwortlichkeiten und Business-KPIs zuordnen

-

Simulation ergänzen, sobald Datenqualität und Governance dies erlauben

Entscheidungsreife Einblicke reduzieren reaktive Ad-Hoc-Handlungen und verbessern die Priorisierung, indem sie Performance greifbar machen: Teams sehen, was sich verändert hat, wer dafür verantwortlich ist und ob die Maßnahme Wirkung gezeigt hat.

Empfehlungen für die Umsetzung:

-

Pro kritischem Prozess ein schlankes KPI-Set mit klarer Verantwortung definieren

-

Erkenntnisse direkt mit Korrekturmaßnahmen und Freigabeentscheidungen verknüpfen

Sind Erkenntnisse umsetzbar, wird das Geschäftsprozessmanagement zum Fundament für Transformation.

Trend 7: GPM als Rückgrat der Automatisierung

Automatisierung behebt keine unklaren Prozesse – sie skaliert sie.

Im Jahr 2026 wird Geschäftsprozessmanagement zum Rückgrat der Transformation, weil es Klarheit, Verantwortung und Nachvollziehbarkeit in zunehmend fragmentierten Automatisierungslandschaften schafft. Erfolgreiche Automatisierung baut auf allem auf, was davor kommt: nutzbaren Prozessen, gesteuerter KI-Unterstützung, ausführungsspezifischen Nachweisen, integrierter Compliance und standardisierten Baselines.

Fehlen diese Grundlagen, verstärkt Automatisierung Inkonsistenzen und Ausnahmen. Sind sie vorhanden, wird Automatisierung wiederholbar, messbar und nachhaltig.

Warum GPM mit zunehmender Automatisierung noch wichtiger wird

Automatisierungsmuster werden leistungsfähiger und autonomer. Analystenstudien, unter anderem von Gartner, zeigen ein wachsendes Interesse an KI-gestützter und agentenbasierter Automatisierung – machen jedoch zugleich deutlich, dass Initiativen ins Stocken geraten, wenn Governance, Wertdefinition und operative Steuerung fehlen.

Die Konsequenz für das GPM ist eindeutig: Je leistungsfähiger die Automatisierung, desto geringer die Toleranz für Unklarheit.

Selbst fortgeschrittene Automatisierung ist auf GPM angewiesen, um bereitzustellen:

-

verlässlichen Kontext (freigegebene Prozesse, Verantwortlichkeiten, Regeln)

-

klare Ownership- und Freigabelogiken

-

messbare und auditierbare Ergebnisse

GPM bleibt die Ebene, die sicherstellt, dass Automatisierung auf dem basiert, was passieren soll – nicht nur auf dem, was technisch automatisierbar ist.

Skalierbare Automatisierung folgt einer disziplinierten Logik

Erfolgreiche Automatisierungsinitiativen folgen durchgängig derselben Abfolge:

-

Prozess-Baseline definieren und freigeben

-

Mithilfe von Nachweisen Verbesserungs- und Automatisierungskandidaten identifizieren

-

Änderungen über Freigaben steuern

-

Ergebnisse gegen die ursprünglichen Ziele messen

Genau hier scheitern viele Automatisierungsvorhaben. Teams springen häufig zu schnell von der Absicht zur Umsetzung und automatisieren Abläufe, die noch nicht stabil, messbar oder ausreichend verstanden sind. Ohne verlässliche Prozess-Baseline und ausführungsspezifische Transparenz werden Annahmen direkt in Code gegossen.

Eine detaillierte Einordnung dazu findet sich in „Warum Automatisierung häufig scheitert – und wie sie mit ADONIS gelingt“.

Empfehlungen für die Umsetzung:

-

Freigegebene Prozess-Baselines als Voraussetzung für Automatisierungsvorschläge festlegen

-

Automatisierung als gesteuerte Veränderung behandeln, nicht als technischen Shortcut

-

Ergebnisse nach der Umsetzung messen und Automatisierungen mit geringer Wirkung konsequent zurücknehmen

2026 macht GPM zur operativ intelligenten Disziplin

Geschäftsprozessmanagement entwickelt sich von einer Dokumentationsdisziplin zu einer steuernden operativen Fähigkeit. Dessen Wert bemisst sich 2026 nicht daran, ob Prozesse existieren, sondern daran, wie effektiv sie genutzt, gesteuert, verbessert und skaliert werden.

Organisationen, die erfolgreich sind, setzen GPM in der richtigen Reihenfolge um: Adoption, Beschleunigung, Evidenz, Governance, Skalierung, Erkenntnis und Transformation.

Wie Organisationen auf diesen Wandel reagieren, entscheidet darüber, ob GPM zu einer stabilisierenden Kraft wird – oder ein ungenutztes Potenzial bleibt. Für alle, die den nächsten Schritt gehen wollen, verschiebt sich der Fokus nun vom Verständnis der Trends hin zur konkreten Umsetzung.

Erfahren Sie, wie ADONIS diese Entwicklung unterstützt – von Prozesserlebnis und KI-Unterstützung über Process Mining und Governance bis hin zur Ermöglichung von Automatisierung.

Referenzen:

BPM Study 2025 (ZHAW School of Management and Law with BOC Group): key facts and study overview. www.boc-group.com

Gartner reports on AI-ready data, GenAI project abandonment, Agentic AI risk, and Hype Cycle framing. 1 2 3 4

Deloitte Global’s 2025 Predictions Report: Generative AI. Deloitte

McKinsey report on the state of AI in organizations. McKinsey & Company

Deloitte Global Process Mining Survey 2025. Deloitte

Gartner process mining / digital twin direction as cited by IBM. ibm.com

van der Aalst (process mining tutorial foundations, discovery and conformance concepts). vdaalst.rwth-aachen.de

ISO 37301 (Compliance management systems). APQC

COSO Internal Control – Integrated Framework (control activities embedded in operations). ISO

APQC Process Classification Framework (process architecture and common language). ISO

ISO 9001:2015 (performance evaluation and continual improvement principles). ISO

ADONIS documentation and knowledge hub pages (Process Portal, Release Workflows, Comments, Read & Explore state filtering, AI Assistant).Model Context Protocol (MCP) specification and overview. GitHub