Uważasz, że to było pomocne? Podziel się tym z innymi.

Wprowadzenie: Odpowiedzialne AI zaczyna się od solidnych podstaw GRC

Sztuczna inteligencja (AI) ma potencjał, by zrewolucjonizować biznes, ale bez odpowiedniej struktury może narażać firmy na nowe ryzyka etyczne, regulacyjne i operacyjne. Zarówno badacze, jak i praktycy podkreślają, że AI zmienia nie tylko technologię – zmienia same ryzyka.

Od zagrożeń związanych z prywatnością danych, przez niejasne procesy decyzyjne, po szybko zmieniające się przepisy – AI kwestionuje fundamenty działania i zarządzania organizacjami. Właśnie tutaj wchodzi w grę GRC.

Zanim będzie można skalować AI w sposób odpowiedzialny, potrzebna jest struktura zaufania: solidne zarządzanie danymi, dojrzałe zarządzanie ryzykiem i egzekwowalne mechanizmy zgodności. To fundamenty, które sprawiają, że AI jest nie tylko potężna, ale też bezpieczna, strategiczna i trwała.

W tym artykule przyglądamy się, co naprawdę oznacza „gotowość na AI” z perspektywy GRC i jak platformy takie jak ADOGRC pomagają firmom przejść od wizji do realizacji.

GRC jako klucz do bezpiecznego i etycznego wykorzystania AI

Od automatyzacji rutynowych zadań po wspieranie decyzji o wysokiej wadze – AI kształtuje zarówno procesy biznesowe, jak i związane z nimi ryzyka. W centrum tej zmiany znajduje się GRC. Rosnące znaczenie sztucznej inteligencji przynosi nowe wyzwania, którym zespoły GRC muszą sprostać, by AI pozostało jednocześnie skuteczne i odpowiedzialne.

- AI zwielokrotnia ryzyka we wszystkich obszarach. Przetwarza ogromne i wrażliwe zbiory danych – osobowych, finansowych i operacyjnych – co rodzi poważne obawy dotyczące prywatności, bezpieczeństwa oraz zgodności z przepisami, zwłaszcza tam, gdzie brakuje odpowiedniego nadzoru. GRC musi śledzić pochodzenie danych, zapewniać przejrzystość decyzji oraz utrzymywać jasne struktury kontroli.

- Sztuczna inteligencja może też wprowadzać uprzedzenia, podejmować nieprzejrzyste decyzje i naruszać standardy etyczne. Jednocześnie zwiększa złożoność regulacyjną, ponieważ prawo i wytyczne nie nadążają za tempem rozwoju technologii.

- Bez odpowiednich mechanizmów nadzoru AI staje się „czarną skrzynką”. Brak ludzkiej walidacji i przejrzystości może prowadzić do decyzji, których nie da się ani wytłumaczyć, ani zweryfikować.

Wszystko to sprawia, że GRC staje się kluczowe nie tylko dla zarządzania ryzykiem, lecz także dla bezpiecznego i strategicznego wykorzystania AI.

Trzy filary odpowiedzialnego wdrażania AI w GRC

Aby korzystać z AI w sposób odpowiedzialny i skalowalny, firma musi opierać swoje działania na mocnych fundamentach GRC – zarządzanie ładem korporacyjnym, ryzykiem i zgodnością są tu kluczowe.

3 filary gotowości GRC na AI

1. Zarządzanie danymi i ochrona danych

Dlaczego jest to ważne: Systemy AI są tak dobre, jak dane, na których się opierają. Słabe zarządzanie danymi może prowadzić do stronniczych wyników, naruszeń prywatności lub decyzji bez jasnych reguł odpowiedzialności.

Dzięki ADOGRC możesz:

- Definiować role, odpowiedzialności i ścieżki eskalacji dla inicjatyw AI

- Mapować wrażliwe zasoby danych do odpowiednich procesów i mechanizmów kontroli

- Przeprowadzać uporządkowane oceny ryzyka związane z dostępem i wykorzystaniem danych AI

- Uwzględniać kwestie etyczne i ESG w procesach zatwierdzania dzięki scentralizowanej bibliotece zgodności

- Monitorować, jak AI jest zgodne z regulacjami i celami strategicznymi za pomocą kokpitów i zintegrowanych przepływów pracy

Kolejny krok: Wdrożenie ciągłego monitoringu integralności danych, okresu przechowywania i ryzyk związanych z prywatnością w systemach AI – wykrywanie luk, konfliktów i problemów etycznych zanim technologia zostanie zaimplementowana.

2. Zarządzanie ryzykiem i system kontroli wewnętrznej

Dlaczego ma to znaczenie: AI wprowadza nowe kategorie ryzyka – od zniekształceń w modelach oraz odchyleń w działaniu, po nieprzejrzyste procesy decyzyjne i niepewność regulacyjną. Bez odpowiednich mechanizmów kontroli te ryzyka mogą szybko eskalować.

Dzięki ADOGRC możesz:

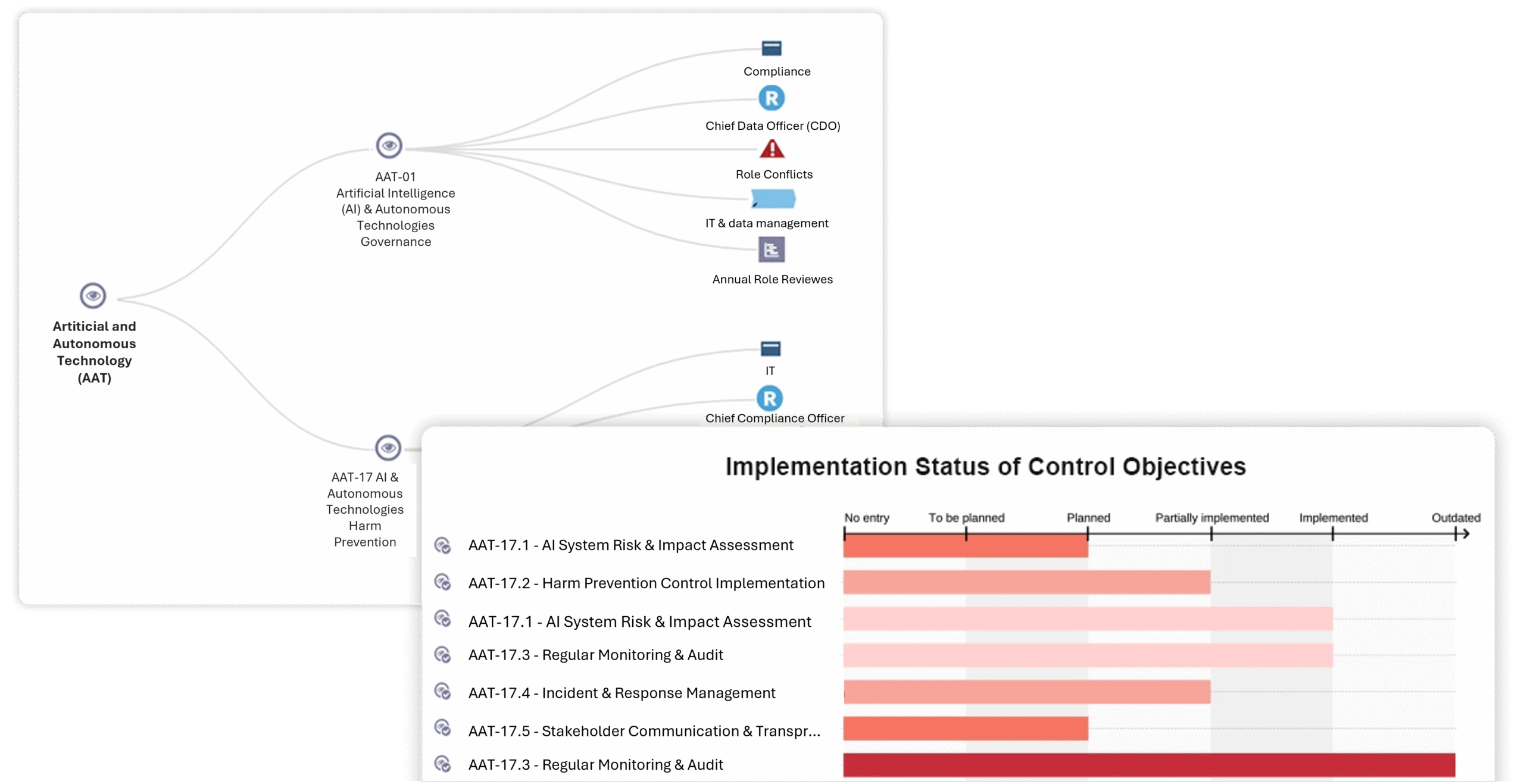

- Identyfikować i klasyfikować ryzyka specyficzne dla AI we wszystkich obszarach

- Powiązać modele i systemy AI z rejestrem ryzyka

- Przypisywać przypadki użycia AI do rejestrów ryzyka i kontroli w ramach procesów

- Wdrażać mechanizmy kontroli dla przejrzystości, wyjaśnialności i walidacji modeli

- Mapować komponenty AI do istniejących, dopasowanych rejestrów w celu zachowania pełnej kontroli nad wszystkimi obiektami GRC

- Zarządzać procesami mitygacji ryzyka, monitorować skuteczność działań oraz prowadzić rutyny monitoringu i reagowania na incydenty

Wdrażanie wymagań AI Act w codzienne działania firmy

Kolejny krok: Zintegruj predykcyjne ocenianie ryzyka dla aktywów powiązanych z AI i zautomatyzuj wykrywanie luk w kontrolach.

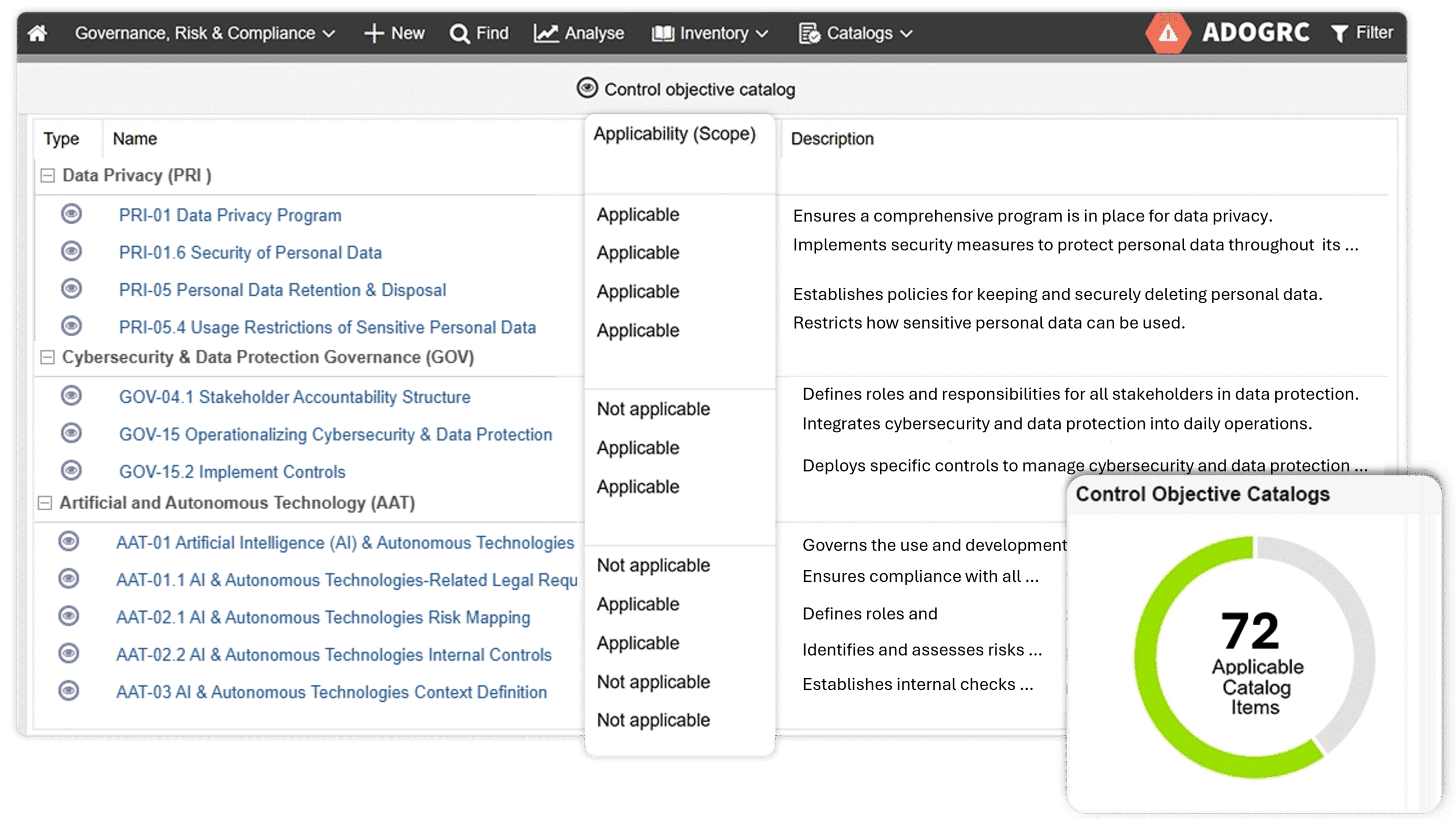

3. Zgodność z przepisami i regulacjami

Dlaczego ma to znaczenie: Nowe regulacje, takie jak unijny Akt o sztucznej inteligencji (ang. AI Act), będą wymagały uporządkowanej klasyfikacji, dokumentacji i możliwości audytu systemów AI zarówno w fazie rozwoju, jak i użytkowania.

Dzięki ADOGRC możesz:

- Dopasować rozwój AI do standardów takich jak ISO/IEC 42001 czy NIST AI RMF, korzystając ze scentralizowanej biblioteki zgodności

- Prowadzić rejestr ryzyk specyficznych dla AI oraz ich ocen w celu wdrażania działań korygujących

- Łączyć wymagania regulacyjne ze środkami kontroli, zatwierdzeniami i dokumentacją

- Monitorować ryzyka specyficzne dla AI i podjęte działania za pomocą scentralizowanego kokpitu i raportów, by być zawsze przygotowanym do audytu

Dopasowany zakres wymagań AI Act

Następny krok: Twórz dynamiczne kokpity zgodności i automatycznie generuj wymagane sprawozdania, zmniejszając ilość pracy manualnej i pozostając zawsze na bieżąco względem obowiązujących regulacji oraz interesariuszy.

Wskazówka: Pomyśl o tych filarach jak o „siatce bezpieczeństwa” AI – wychwytują luki w zgodności, ograniczają ryzyko i pomagają utrzymać zaufanie regulatorów.

Od zasad do praktyki: Wdrażanie zarządzania AI w codziennych procesach

Wiele firm posiada zasady dotyczące AI, ale tylko nieliczne mają modele operacyjne, które tworzą warunki do odpowiedzialnego i – co najważniejsze – kompleksowego wdrożenia.

Przykład zastosowania: Zarządzanie AI w obsłudze klienta

Wyobraź sobie, że Twój zespół obsługi klienta zaczyna korzystać z asystenta AI, który pomaga szybciej obsługiwać zgłoszenia klientów. Jak sprawić, żeby to rozwiązanie było bezpieczne i zgodne z przepisami – zamiast przynieść problemy?

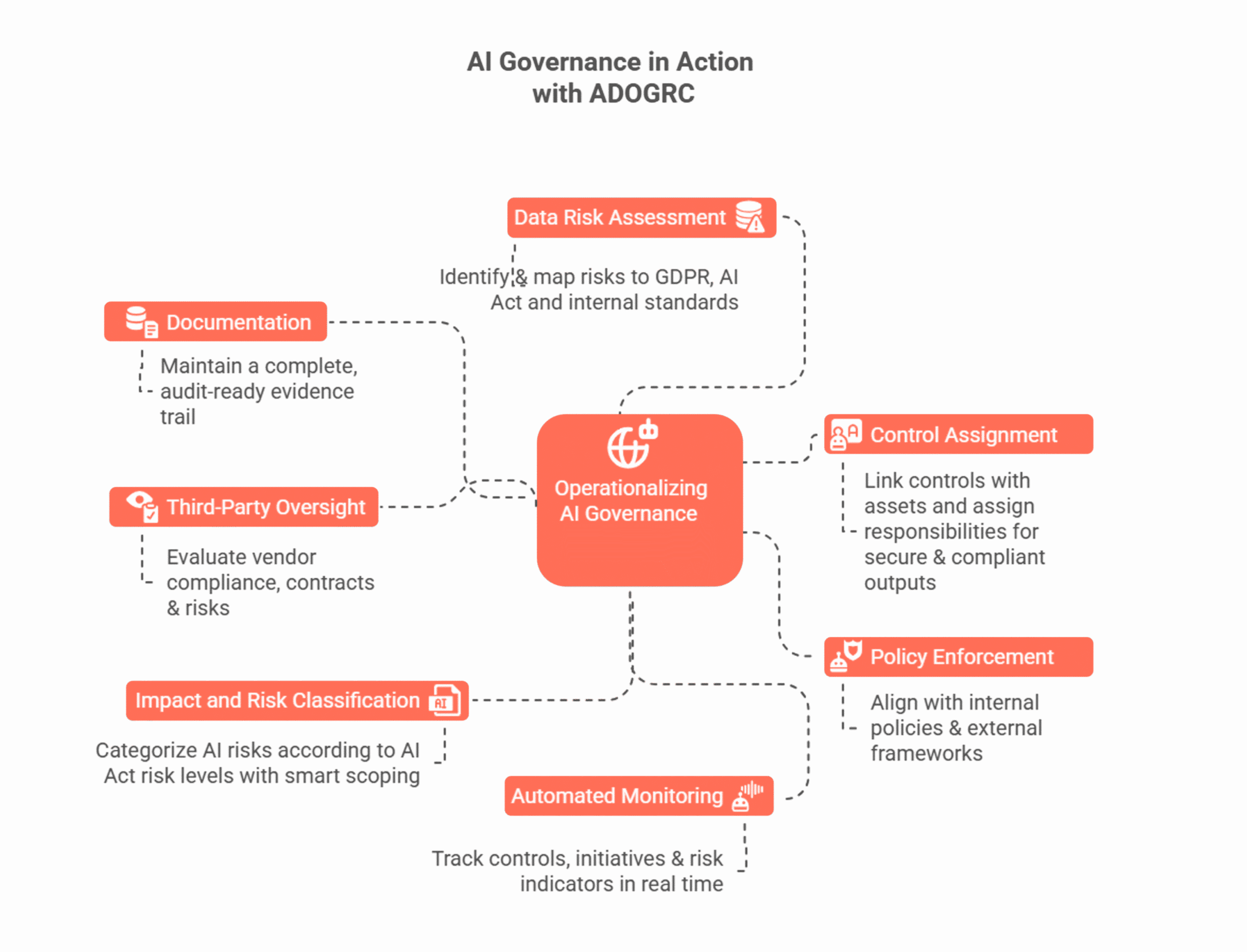

Z ADOGRC możesz:

1. Ocenić ryzyko związane z danymi

Analizuj zagrożenia dotyczące danych osobowych klientów za pomocą ustrukturyzowanych ocen wymagań i powiąż je bezpośrednio z obowiązkami wynikającymi z RODO, wymaganiami AI Act oraz wewnętrznymi standardami bezpieczeństwa danych – tak, aby asystent AI nie ujawniał wrażliwych informacji.

2. Przypisać kontrole

Ustal, kto odpowiada za poszczególne działania i jakie kontrole należy wprowadzić. Dzięki temu ważne procesy – takie jak ponowne uczenie modelu, nadzór ludzki i ochrona danych – są prowadzone w sposób uporządkowany, a wyniki generowane przez AI pozostają zgodne z przepisami, bezpieczne i aktualne.

3. Egzekwuj polityki

Powiąż sposób wykorzystania AI z wewnętrznymi zasadami zarządzania sztuczną inteligencją oraz zewnętrznymi standardami, takimi jak ISO 42001. Dzięki temu asystent AI będzie działał zgodnie z zasadami firmy i obowiązującymi przepisami.

4. Monitorować na bieżąco

Wykorzystuj kokpity i raporty, aby śledzić skuteczność wprowadzonych kontroli, otwarte zadania oraz wskaźniki ryzyka w czasie rzeczywistym, zanim problemy się nasilą.

5. Klasyfikować ryzyko

Określ poziom ryzyka asystenta AI zgodnie z wymogami AI Act i w inteligentny sposób wyznacz zakres obowiązków, koncentrując się tylko na tym, co naprawdę istotne, w ramach Twojej spersonalizowanej biblioteki zgodności.

6. Sprawdzać zewnętrznych dostawców

Jeśli model AI pochodzi od zewnętrznego dostawcy, zweryfikuj jego zgodność z przepisami, umowami i standardami ryzyka, aby utrzymać wiarygodny łańcuch dostaw asystenta AI. Dzięki funkcji zarządzania ryzykiem dostawców w ADOGRC możesz w jednym miejscu przeanalizować kluczowe informacje o dostawcach – od ich tożsamości i kosztów po wpływ na biznes.

7. Prowadzić pełną dokumentację

Rejestruj każdą akcję, zatwierdzenie, ocenę i zmianę w jednym, centralnym systemie, aby w prosty sposób udowodnić, że asystent AI jest odpowiednio zarządzany, bezpieczny i gotowy do audytu.

Praktyczne podejście do zarządzania AI z ADOGRC

Podsumowanie: Odpowiedzialna AI wymaga odpowiedzialnego zarządzania GRC

W gotowość na AI nie chodzi jedynie o technologię. Chodzi także o strukturę, nadzór i zaufanie.

Dzięki solidnym praktykom GRC możesz zapewnić, że:

-

Ryzyka związane z AI są wczesno identyfikowane i odpowiednio adresowane

-

Polityki są konsekwentnie stosowane i egzekwowane

-

Decyzje podejmowane przez AI można wyjaśnić, audytować i udoskonalać w czasie

Platformy takie jak ADOGRC przekładają te zasady na praktykę, łącząc strategiczną wizję z codziennymi działaniami. Od rejestrów ryzyka po kokpity w czasie rzeczywistym, od centralnych ram zgodności po zautomatyzowane procesy – ADOGRC sprawia, że zarządzanie AI staje się rzeczywistością, a zaufanie, odpowiedzialność i zgodność są wbudowane od pierwszego dnia.

AI zmieni Twój biznes. To, czy transformacja będzie trwała, etyczna i przygotowana na przyszłość, zależy od GRC. Teraz jest czas, aby przygotować organizację na AI – według własnych zasad.