Uważasz, że to było pomocne? Podziel się tym z innymi.

Wstęp

Sztuczna inteligencja (AI) coraz częściej znajduje zastosowanie w firmach. Otwiera przed nimi ogromne możliwości, ale jednocześnie wiąże się z rosnącymi ryzykami. Wiele organizacji zmaga się z nieprzejrzystymi decyzjami, rosnącą złożonością procesów, ochroną danych i niepewnością prawną.

Unijne rozporządzenie o sztucznej inteligencji (AI Act) to pierwszy w Europie akt prawny, który wprost reguluje wykorzystanie AI. Weszło w życie w lipcu 2024 r., a główne obowiązki zaczną obowiązywać od sierpnia 2026 r. Dotyczy to wszystkich organizacji rozwijających lub wykorzystujących systemy AI w UE – w praktyce niemal każdej firmy.

Sprawdź gotowość swojej organizacji, korzystając z naszego szablonu EU AI Act Readiness Check, i dowiedz się, czy Twoje systemy AI spełniają wymagania rozporządzenia.

Firmy muszą zapewnić przejrzystość w przetwarzaniu danych oraz nadzorze nad systemami AI. Ważne jest także, aby udowodnić, że systemy działają bezpiecznie i zgodnie z obowiązującymi przepisami.

W tym artykule pokazujemy, jak wymogi AI Act można przełożyć na konkretne działania w obszarze zarządzania oraz w jaki sposób ADOGRC wspiera firmy w budowaniu gotowości na AI.

GRC – pomost do zgodności z AI Act

Dla organizacji, które chcą wprowadzać AI w sposób odpowiedzialny, kluczowe jest, by nie postrzegać systemów AI osobno, lecz w kontekście jasno zdefiniowanych struktur. Rozporządzenie AI Act jasno pokazuje, że odpowiedzialne wykorzystanie AI jest możliwe tylko wtedy, gdy firmy potrafią zarządzać ryzykiem i przedstawiać je w sposób przejrzysty.

To właśnie dlatego GRC stanowi fundament zarządzania AI i obejmuje m.in.:

-

Struktury odpowiedzialności i kontroli, które jasno określają, kto i za jakie decyzje odpowiada.

-

Procedury oceny ryzyka, pozwalające w porę wykryć stronniczość (ang. biases), nieprzejrzyste decyzje czy luki w bezpieczeństwie.

-

Rzetelną dokumentację i dowody, które spełnią wymagania audytorów i interesariuszy.

-

Budowanie zaufania do AI, dzięki czemu nie jest ona postrzegana jako „czarna skrzynka”, lecz jako śledzalne i wytłumaczalne narzędzie.

Przekładając wymogi AI Act na konkretne procesy, polityki, kontrole i działania, GRC odgrywa kluczową rolę w zapewnieniu zgodności i odpowiedzialnego wykorzystania AI.

Podstawowe wymagania rozporządzenia UE w sprawie AI

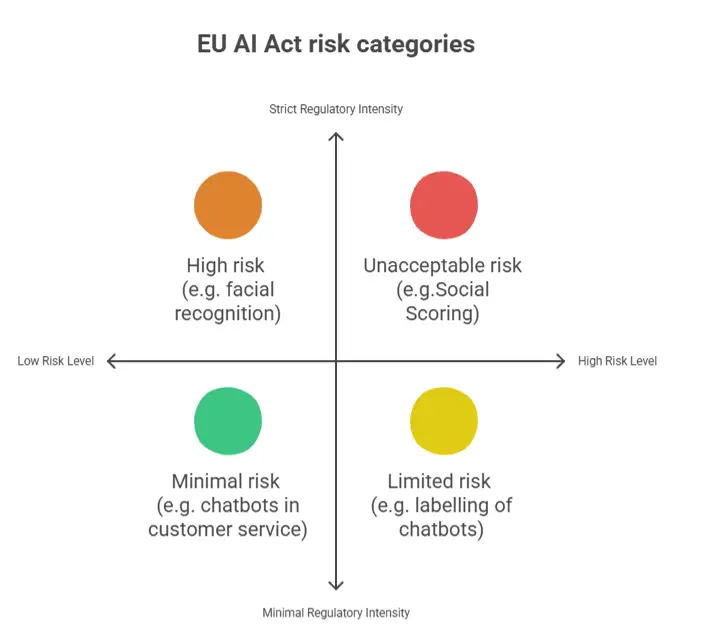

Aby ocenić związane z tym ryzyka, rozporządzenie UE w sprawie AI klasyfikuje systemy AI w określone kategorie ryzyka:

- Ryzyko niedopuszczalne: zabronione (np. scoring społeczny).

- Ryzyko wysokie: obowiązkowe rygorystyczne wymagania dotyczące dokumentacji, jakości danych i nadzoru ludzkiego.

- Ryzyko ograniczone: obowiązki w zakresie przejrzystości (np. oznaczanie chatbotów).

- Ryzyko minimalne: obowiązują tu jedynie nieliczne wymagania.

Kategorie ryzyka według AI Act

Systemy te wiążą się z szeregiem obowiązków:

-

Dokumentacja i dowody obejmujące dane, procesy treningowe oraz ścieżki podejmowania decyzji.

-

Przejrzystość i wytłumaczalność modeli.

-

Nadzór ludzki, umożliwiający kontrolę i monitorowanie kluczowych decyzji.

-

Audytowalność – zapewnienie możliwości przeglądu i śledzenia systemów w dowolnym momencie.

Spełnienie tych wymagań jest praktycznie niemożliwe bez wprowadzenia ustrukturyzowanego systemu zarządzania.

Według Gartner® (2024) 57% organizacji nie posiada struktur i mechanizmów kontroli potrzebnych do bezpiecznego wdrożenia AI. Innymi słowy, większość organizacji nie jest jeszcze gotowa na AI, co sprawia, że podjęcie działań w tym zakresie staje się pilnym priorytetem.

GRC jako klucz do gotowości na AI Act

Odpowiedzialne wykorzystanie AI wymaga solidnych fundamentów – takich, jakie zapewnia GRC. Jego trzy kluczowe wymiary bezpośrednio przekładają się na gotowość do EU AI Act:

1. Zarządzanie danymi i ich ochrona

Zapewnij i udokumentuj pochodzenie oraz jakość danych treningowych. Organizacje muszą w każdej chwili móc udowodnić, skąd pochodzą ich dane i czy nadają się do budowy wiarygodnych modeli AI.

Spójnie dostosuj wymagania RODO i AI Act. Muszą one być harmonizowane z zasadami jakości danych i przejrzystości przewidzianymi w AI Act.

2. Zarządzanie ryzykiem i kontrola wewnętrzna

Identyfikuj ryzyka specyficzne dla AI, takie jak stronniczość, awarie modelu czy błędne decyzje.

Wdrażaj mechanizmy kontroli w zakresie przejrzystości, walidacji modeli oraz nadzoru ludzkiego. Ustrukturyzowane podejście do nadzoru i monitorowania zapewnia, że decyzje pozostają wytłumaczalne i kontrolowalne.

3. Zgodność i dostosowanie regulacyjne

Integruj wymagania AI Act ze standardami takimi jak ISO/IEC 42001 czy NIST AI RMF, osadzając je w istniejących ramach zarządzania zgodnością.

Przechowuj wszystkie dowody, oceny i działania w scentralizowany sposób, aby zapewnić audytowalność i długoterminową śledzalność.

Dzięki solidnym fundamentom GRC organizacje tworzą zintegrowany system kontroli, który sprawia, że wdrożenie AI jest nie tylko zgodne z przepisami, ale także skalowalne i wiarygodne. Standaryzując procesy, definiując odpowiedzialności i systematycznie zarządzając ryzykiem, organizacje stają się gotowe na AI.

Sprawdź: Dowiedz się więcej o roli GRC w zapewnieniu odpowiedzialnego, bezpiecznego i skalowanego wykorzystania AI.

Od zasad do procesów: wdrażanie AI Act z ADOGRC

Wiele organizacji już zdefiniowało swoje wytyczne dotyczące AI – często jednak brakuje im modeli operacyjnych, które pozwalałyby je skutecznie egzekwować. Właśnie tutaj wkracza ADOGRC.

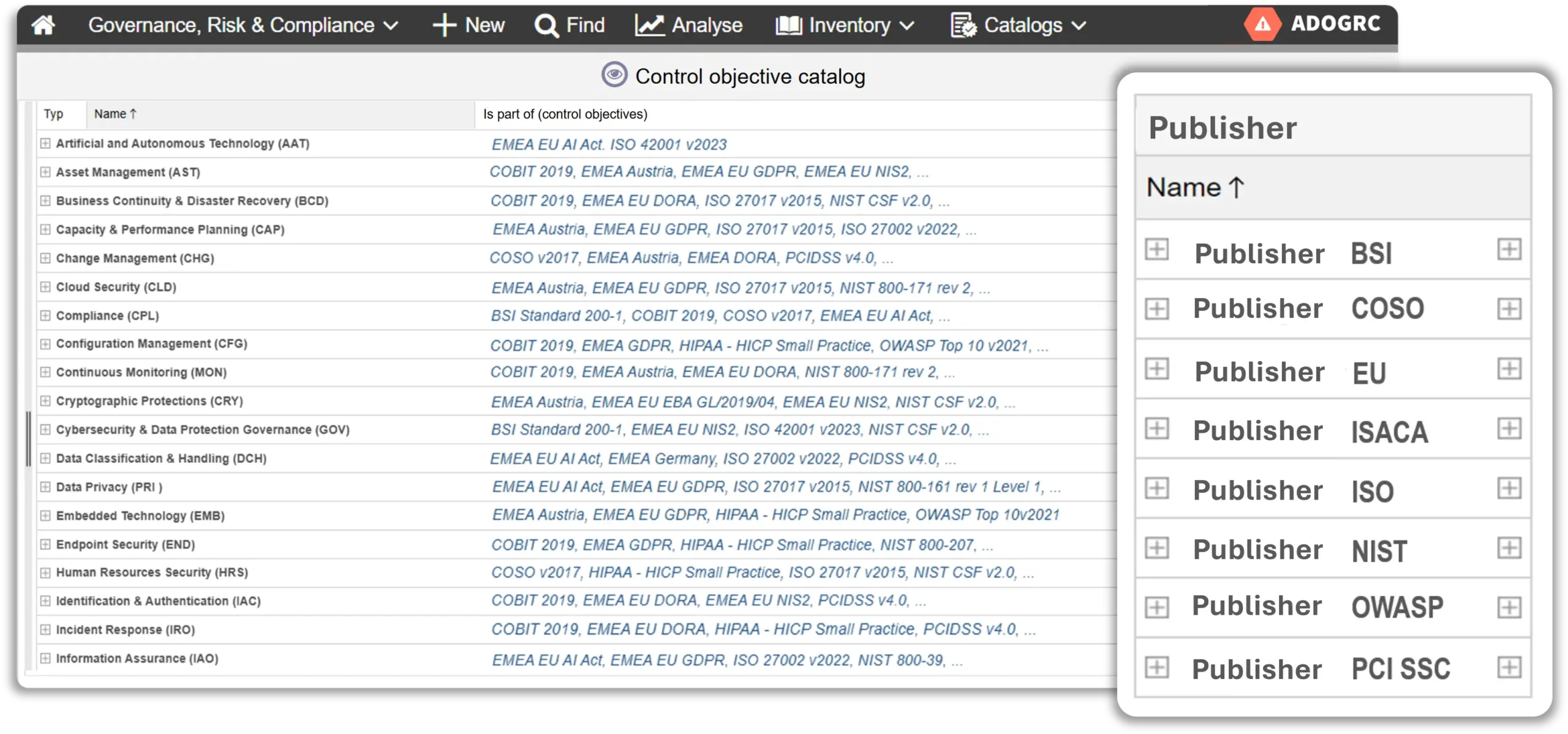

Centralna biblioteka zgodności

Wszystkie wymagania regulacyjne – od AI Act po standardy branżowe – są rejestrowane, utrzymywane i aktualizowane centralnie w ramach ADOGRC. Dzięki temu powstaje jedno źródło prawdy dla wszystkich obowiązków związanych z AI.

Biblioteka zgodności ADOGRC

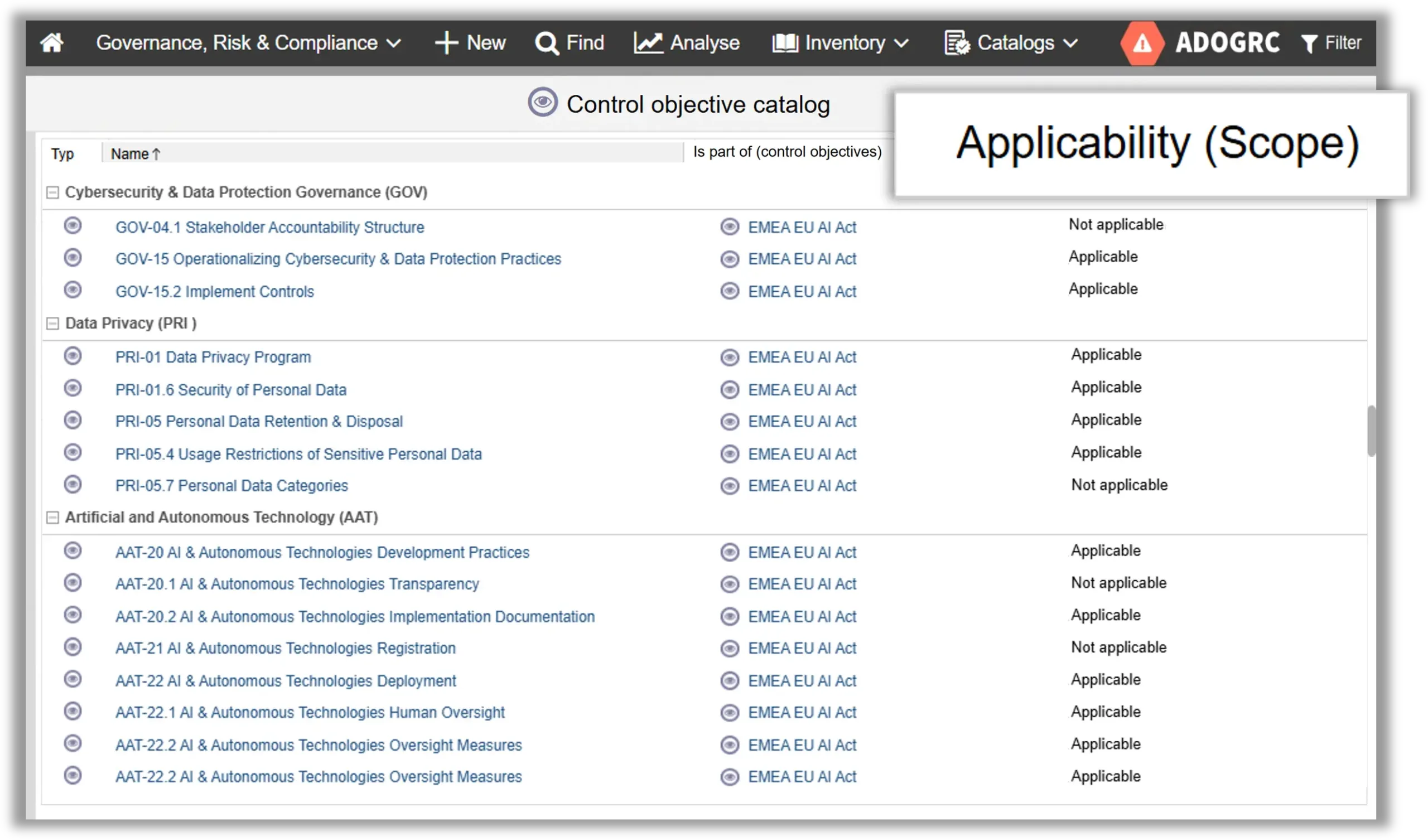

Określanie zakresu i ocena istotności

Przegląd istotnych wymagań

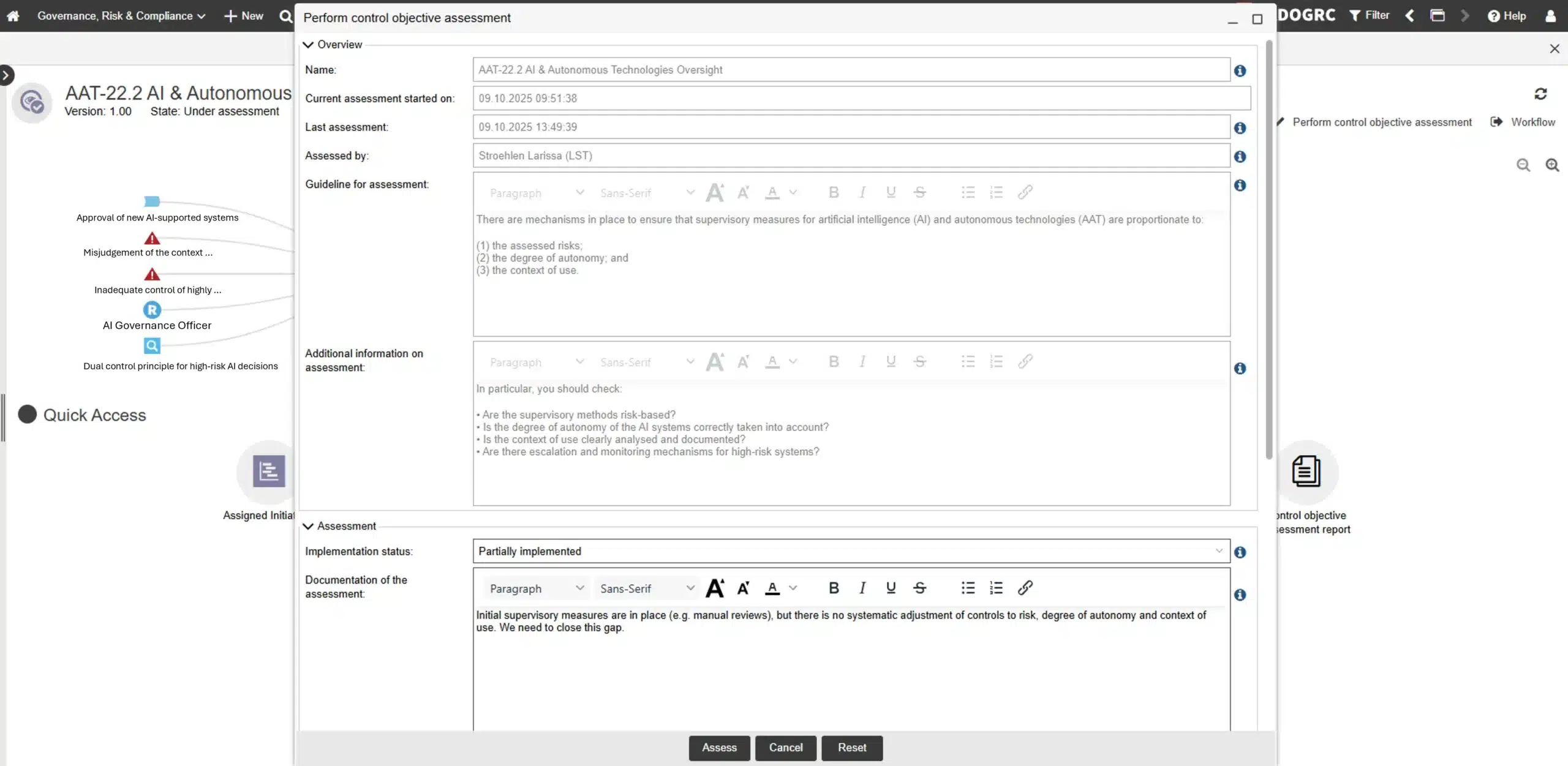

Ocena odporna na audyt

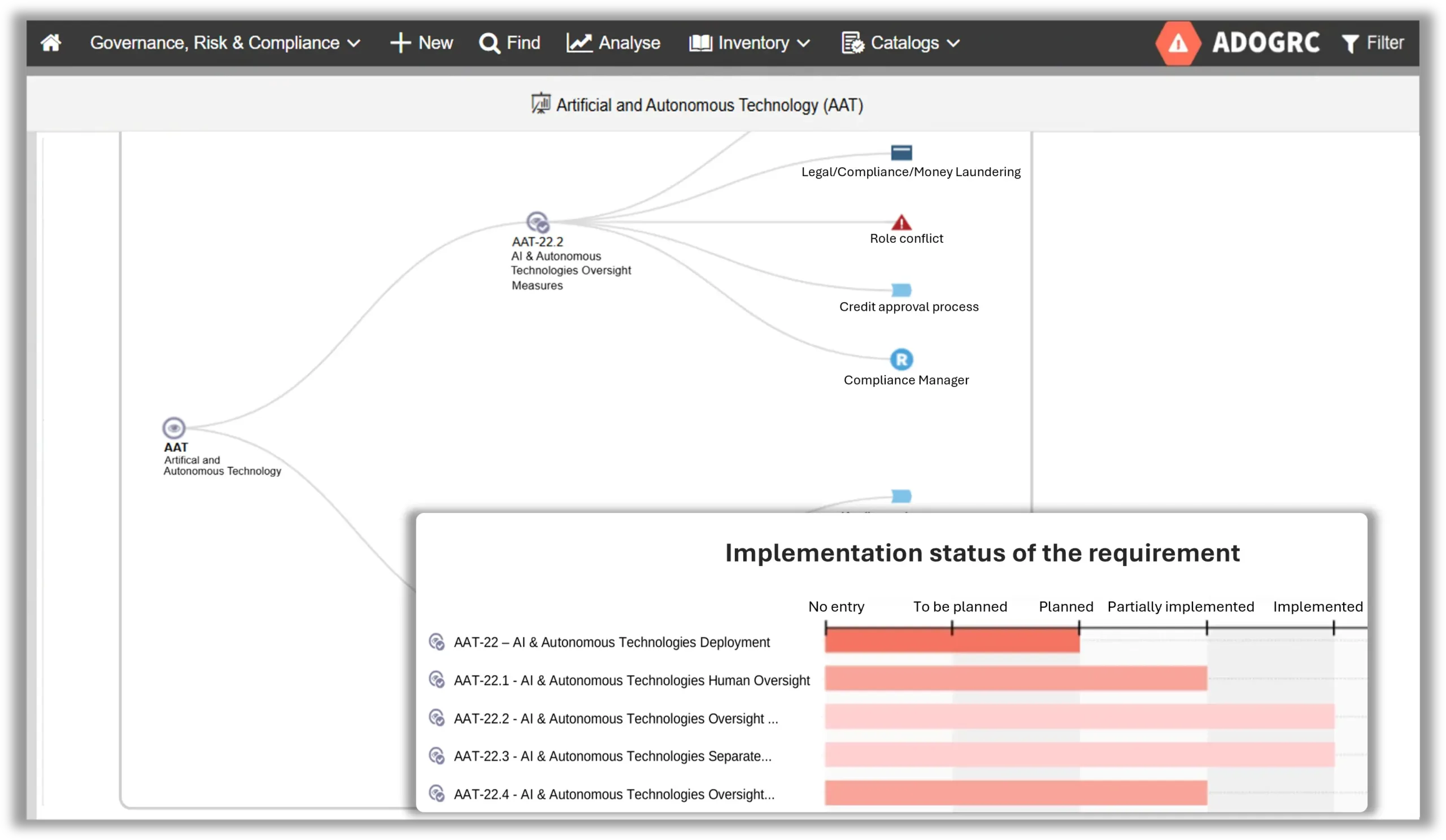

Dzięki standaryzowanym ocenom w ADOGRC możesz zweryfikować, czy wymagania AI Act są spełniane – w sposób udokumentowany, śledzalny i gotowy do audytu. Szczegółowe widoki pozwalają natychmiast zidentyfikować luki i obszary wymagające poprawy.

Szczegółowy widok oceny wymagań

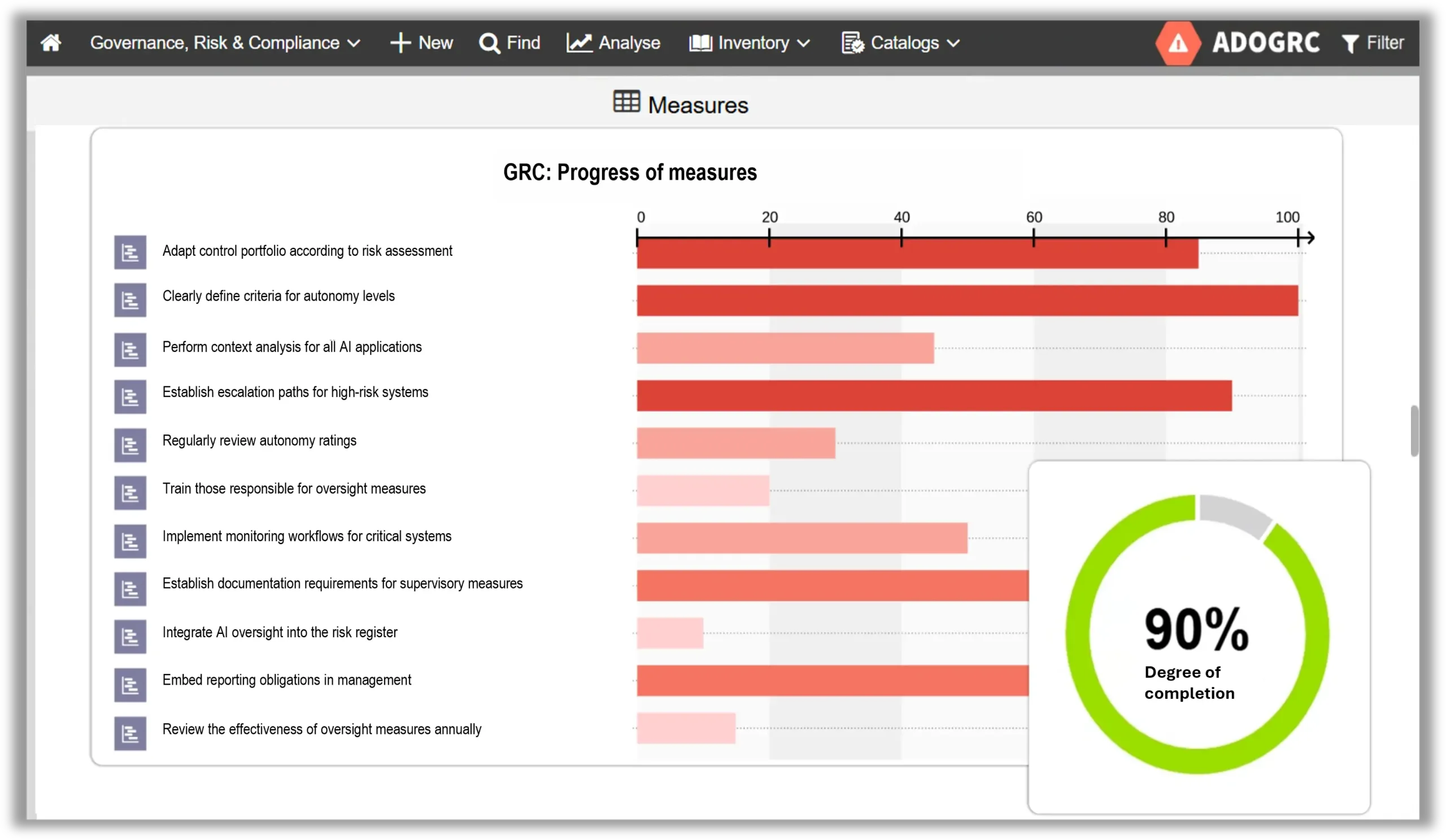

Śledzenie działań

Na podstawie oceny wymagań możesz definiować i zarządzać działaniami bezpośrednio w ADOGRC. Platforma zapewnia, dzięki zautomatyzowanym przepływom pracy, że odpowiedzialności są przypisane, terminy ustalone, a postępy dokumentowane w sposób przejrzysty. Dzięki temu żaden krok w procesie zgodności z AI nie umyka uwadze.

Zakotwiczenie zgodności

Dzięki ADOGRC zgodność z wymaganiami dotyczącymi AI jest osadzona bezpośrednio w procesach Twojej organizacji. Polityki, odpowiedzialności i punkty kontrolne są zintegrowane w przepływach pracy, dzięki czemu zarządzanie przestaje być statycznym dokumentem, a staje się częścią codziennej pracy.

Bezpośrednie powiązanie polityk, odpowiedzialności i kontroli z procesami

Studium przypadku: Zgodność z AI Act w obsłudze klienta

Wyobraź sobie typowy scenariusz: firma wdraża asystenta AI w obsłudze klienta, aby szybciej przetwarzać zapytania. Jak jednak zapewnić, że jego użycie jest zgodne z wymaganiami AI Act? Dzięki ADOGRC staje się to możliwe.

Klasyfikacja

Asystent AI zostaje zakwalifikowany jako system o ograniczonym ryzyku zgodnie z AI Act, ponieważ obowiązują wymagania w zakresie przejrzystości – użytkownicy muszą być poinformowani, że mają do czynienia z systemem AI.

Ocena ryzyk

Na podstawie określonych wymagań przetwarzane dane są sprawdzane pod kątem zgodności z RODO, a funkcjonalność asystenta AI weryfikowana pod kątem zgodności z AI Act.

Definiowanie i dokumentowanie działań

Oprócz wdrażania kontroli definiowane są jednorazowe działania, np. aktualizacja polityki prywatności lub wdrożenie funkcji informującej użytkownika. Wszystkie działania są dokumentowane i wersjonowane centralnie w ADOGRC, dostępne w każdej chwili.

Zapewnienie śledzalności

W przypadku audytów wewnętrznych lub przeglądów zewnętrznych ADOGRC dostarcza przejrzyste dowody wszystkich wdrożonych działań, kontroli i przypisanych odpowiedzialności.

Efekt? Dzięki ADOGRC innowacje pozostają możliwe, a ryzyko regulacyjne jest minimalizowane.

Podsumowanie: AI Act jako szansa na zrównoważone zarządzanie AI

AI Act jasno pokazuje, że sztuczna inteligencja może w pełni wykorzystać swój potencjał tylko wtedy, gdy jest zarządzana w sposób odpowiedzialny. Organizacje, które holistycznie integrują solidne fundamenty GRC w swojej strategii, mogą wcześnie identyfikować ryzyka, operacjonalizować kontrole oraz przekładać wymagania regulacyjne na konkretne działania.

AI zasadniczo zmienia sposób funkcjonowania organizacji. To GRC decyduje, czy ta transformacja przebiega pod presją regulacyjną, czy jako strategiczny krok wzmacniający organizację w dłuższej perspektywie.